Con la ayuda de Pink Floyd

La música se puede reconstruir a partir de la actividad de la corteza auditiva humana utilizando modelos de decodificación no lineales.

|

Resumen La música es fundamental para la experiencia humana, pero aún se desconoce la dinámica neuronal precisa que subyace a la percepción musical. Analizamos un conjunto de datos único de electroencefalografía intracraneal (iEEG) de 29 pacientes que escucharon una canción de Pink Floyd y aplicó un enfoque de reconstrucción de estímulos utilizado previamente en el dominio del habla. Reconstruimos con éxito una canción reconocible a partir de grabaciones neuronales directas y cuantificamos el impacto de diferentes factores en la precisión de la decodificación. Combinando análisis de codificación y decodificación, encontramos una dominancia del hemisferio derecho para la percepción musical con un papel principal de la circunvolución temporal superior (STG), evidenciamos una nueva subregión STG sintonizada con el ritmo musical y definimos una organización STG anteroposterior que exhibe una expresión sostenida y respuestas de inicio a elementos musicales. Nuestros hallazgos muestran la viabilidad de aplicar modelos predictivos en conjuntos de datos cortos adquiridos en pacientes individuales, allanando el camino para agregar elementos musicales a las aplicaciones de interfaz cerebro-computadora (BCI). |

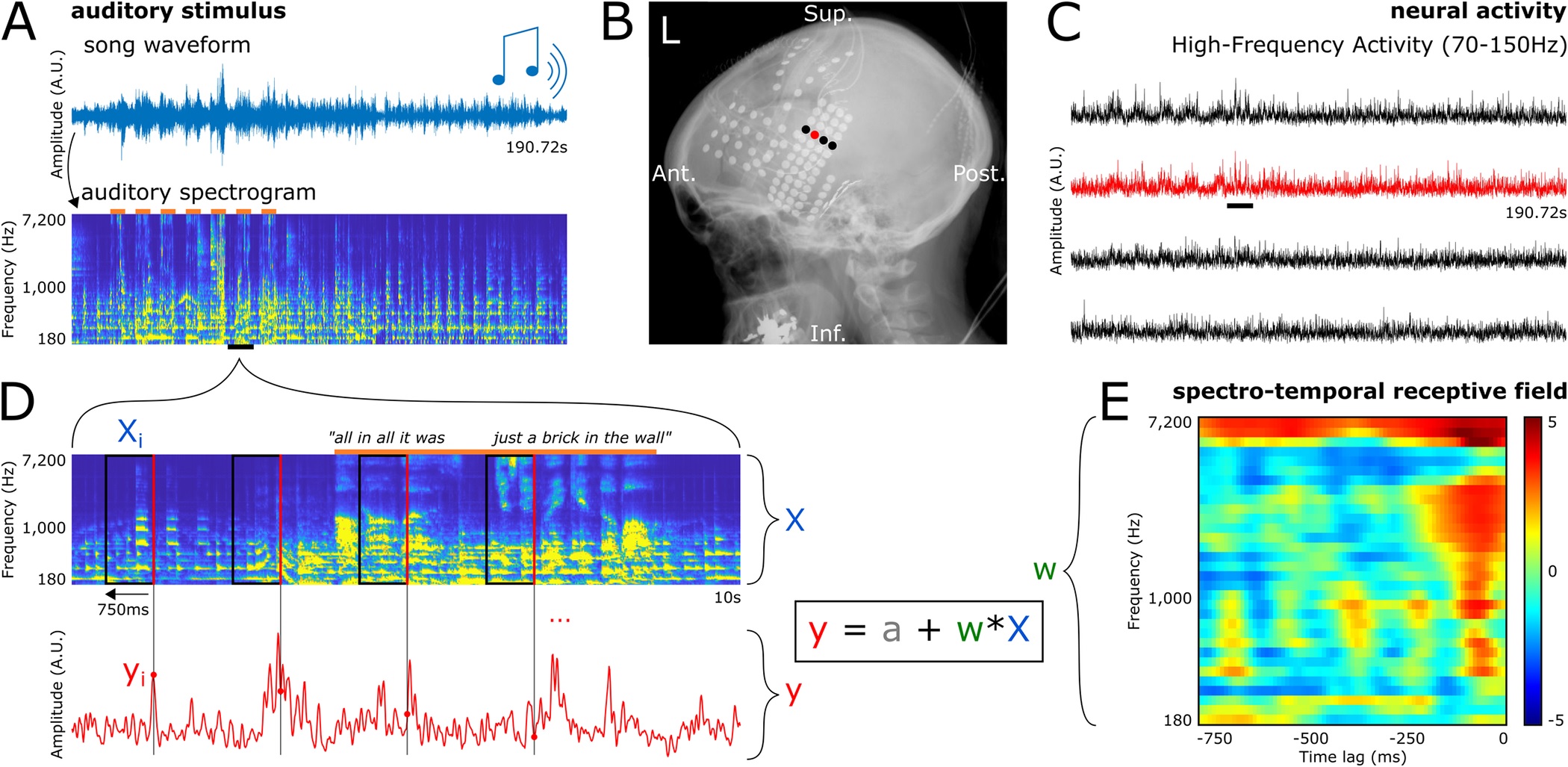

Fig 1. Protocolo, preparación de datos y ajuste del modelo de codificación. (A) Arriba: forma de onda del estímulo de la canción completa. Los participantes escucharon una canción de rock de 190,72 segundos (Another Brick in the Wall, Part 1, de Pink Floyd) utilizando auriculares. Abajo: espectrograma auditivo de la canción. Las barras naranjas en la parte superior representan partes de la canción con voces. (B) Radiografía que muestra la cobertura de los electrodos de 1 paciente representativo. Cada punto es un electrodo y la señal de los 4 electrodos resaltados se muestra en (C). (C) HFA provocado por el estímulo de la canción en 4 electrodos representativos.

Introducción

La música es una experiencia universal en todas las edades y culturas y es una parte central de nuestra vida emocional, cognitiva y social. Comprender el sustrato neuronal que respalda la percepción musical, definido aquí como el procesamiento de sonidos musicales desde la acústica hasta las representaciones neuronales y las percepciones y distintos de la producción musical, es un objetivo central de la neurociencia auditiva. En las últimas décadas se han visto enormes avances en la comprensión de las bases neuronales de la percepción musical, con múltiples estudios que evalúan los correlatos neuronales de elementos musicales aislados como el timbre, el tono, la melodía, armonía y ritmo.

Ambos hemisferios participan en el procesamiento de la música, con una preferencia relativa por el hemisferio derecho en comparación con el dominio izquierdo para el habla. Sin embargo, falta una visión integrada que combine estos elementos musicales y regiones cerebrales específicas utilizando un único enfoque de modelado predictivo aplicado a un estímulo auditivo naturalista y complejo. En este estudio, nuestro objetivo fue especificar qué regiones del cerebro participan preferentemente en la percepción de los diferentes elementos acústicos que componen una canción.

Comentarios

Para aquellos con trastornos neurológicos o del desarrollo que comprometen el habla, las interfaces cerebro-máquina podrían ayudarlos a comunicarse. Pero las interfaces actuales son lentas y, a partir de electrodos colocados en el cuero cabelludo, sólo pueden detectar letras. El discurso generado es robótico y carente de afecto. Los neurocientíficos han demostrado ahora que pueden reconstruir la canción que una persona escucha únicamente a partir de grabaciones cerebrales, lo que ofrece la posibilidad de reconstruir no sólo las palabras sino también la musicalidad del habla, que también transmite significado.

Mientras los acordes de "Another Brick in the Wall, Part 1" de Pink Floyd llenaban la sala de cirugía, los neurocientíficos del Albany Medical Center registraron diligentemente la actividad de los electrodos colocados en los cerebros de pacientes sometidos a cirugía de epilepsia.

¿La meta? Captar la actividad eléctrica de regiones del cerebro sintonizadas con los atributos de la música (tono, ritmo, armonía y palabras) para ver si podían reconstruir lo que el paciente estaba escuchando. Más de una década después, tras un análisis detallado de los datos de 29 de estos pacientes, realizado por neurocientíficos de la Universidad de California, Berkeley, la respuesta es claramente sí.

La frase "En definitiva, era sólo un ladrillo en la pared" se hace reconocible en la canción reconstruida, con sus ritmos intactos y las palabras confusas, pero descifrables. Esta es la primera vez que los investigadores reconstruyen una canción reconocible a partir de grabaciones cerebrales.

La reconstrucción muestra la viabilidad de grabar y traducir ondas cerebrales para capturar los elementos musicales del habla, así como las sílabas. En los seres humanos, estos elementos musicales, llamados prosodia (ritmo, acento, acento y entonación) conllevan un significado que las palabras por sí solas no transmiten.

Debido a que estas grabaciones de electroencefalografía intracraneal (iEEG) solo pueden realizarse desde la superficie del cerebro (lo más cerca posible de los centros auditivos), nadie escuchará a escondidas las canciones en su cabeza en el corto plazo.

Pero para las personas que tienen problemas para comunicarse, ya sea debido a un derrame cerebral o parálisis, estas grabaciones de electrodos en la superficie del cerebro podrían ayudar a reproducir la musicalidad del habla que falta en las reconstrucciones robóticas actuales.

"Es un resultado maravilloso", afirmó Robert Knight, neurólogo y profesor de psicología en el Instituto de Neurociencia Helen Wills de UC Berkeley, quien realizó el estudio con el becario postdoctoral Ludovic Bellier. "Una de las cosas que para mí tiene la música es que tiene prosodia y contenido emocional. A medida que avanza todo este campo de las interfaces cerebro-máquina, esto te brinda una manera de agregar musicalidad a futuros implantes cerebrales para personas que lo necesitan, alguien que tiene ELA o algún otro trastorno neurológico o del desarrollo incapacitante que comprometa la producción del habla. Te da la capacidad de decodificar no sólo el contenido lingüístico, sino parte del contenido prosódico del habla, parte del afecto. Creo que eso es lo que realmente hemos comenzado a descifrar el código encendido."

Comentarios

Para ver los comentarios de sus colegas o para expresar su opinión debe ingresar con su cuenta de IntraMed.