Aprendizaje social mediado por algoritmos en redes sociales en línea

|

Aspectos destacados

|

Resumen

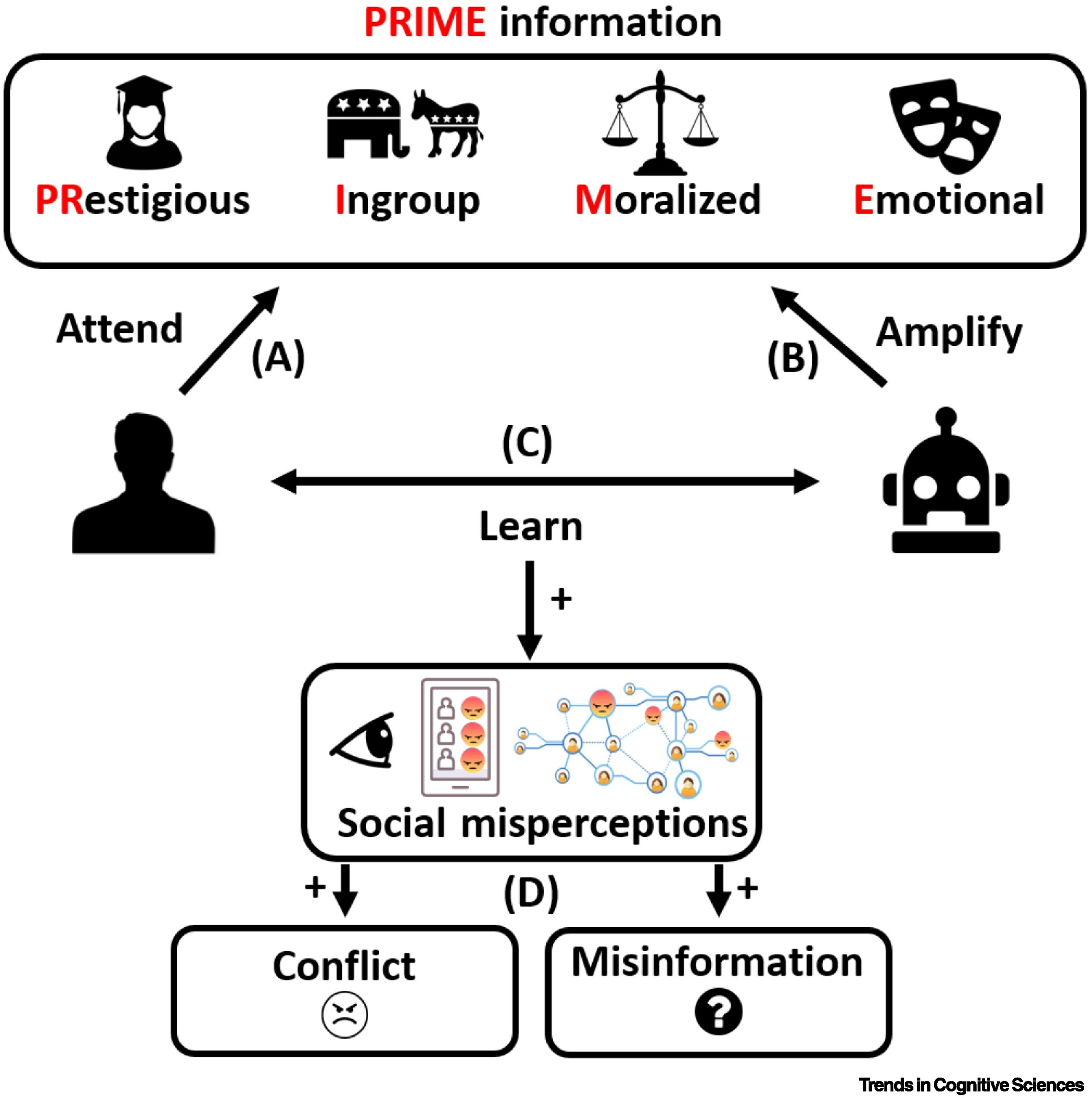

El aprendizaje social humano ocurre cada vez más en las plataformas sociales en línea, como Twitter, Facebook y TikTok. En estas plataformas, los algoritmos explotan los sesgos de aprendizaje social existentes (es decir, hacia la información prestigiosa, moral y emocional del grupo interno, o información 'PRIME') para mantener la atención de los usuarios y maximizar el compromiso. Aquí, sintetizamos ideas emergentes sobre el "aprendizaje social mediado por algoritmos" y proponemos un marco que examina sus consecuencias en términos de desalineación funcional. Sugerimos que, cuando los algoritmos explotan los sesgos de aprendizaje social, la información PRIME se amplifica a través de las interacciones humano-algoritmo en el entorno social digital de manera que causan percepciones sociales erróneas y conflictos, y difunden información errónea. Discutimos soluciones para reducir la desalineación funcional, incluidos algoritmos que promueven la diversificación limitada y aumentan la transparencia de la amplificación algorítmica.

En resumen, cuando los algoritmos de contenido explotan los sesgos de aprendizaje social, se produce un ciclo de retroalimentación de interacción humano-algoritmo que sobrerrepresenta la información PRIME en el entorno y promueve percepciones sociales erróneas que pueden generar conflictos y desinformación en lugar de cooperación y resolución colectiva de problemas.

Resumen gráfico: Aprendizaje social mediado por algoritmos en redes sociales en línea. Durante el aprendizaje social mediado por algoritmos, los algoritmos de contenido en las plataformas de redes sociales explotan los sesgos humanos de aprendizaje social y amplifican la información prestigiosa, moral y emocional ("PRIME") como un efecto secundario de los objetivos para maximizar la participación en las plataformas. Los seres humanos prestan atención naturalmente al contenido PRIME (A) y aprenden a producir más cuando los algoritmos de contenido amplifican la información PRIME (p. ej., a través del aprendizaje por observación y refuerzo) (B, C), creando así un entorno digital que se infla (en relación con la falta de influencia del algoritmo) la cantidad de información PRIME en muchos contextos, como debates sobre moralidad y política. (D) Cuando la información PRIME sobresatura los entornos digitales, puede aumentar el conflicto y facilitar la difusión de información errónea.

Comentarios

En las sociedades prehistóricas, los humanos tendían a aprender de los miembros de su grupo interno o de individuos más prestigiosos, ya que era más probable que esta información fuera confiable y resultara en el éxito del grupo. Sin embargo, con el advenimiento de comunidades modernas diversas y complejas, y especialmente en las redes sociales, estos sesgos se vuelven menos efectivos. Por ejemplo, una persona con la que estamos conectados en línea puede no ser necesariamente confiable, y las personas pueden fingir prestigio fácilmente en las redes sociales. En una revisión publicada en la revista Trends in Cognitive Science, un grupo de científicos sociales describe cómo las funciones de los algoritmos de las redes sociales están desalineadas con los instintos sociales humanos destinados a fomentar la cooperación, lo que puede conducir a una polarización y desinformación a gran escala.

"Varias encuestas de usuarios ahora tanto en Twitter como en Facebook sugieren que la mayoría de los usuarios están agotados por el contenido político que ven. Muchos usuarios no están contentos y hay muchos componentes de reputación que Twitter y Facebook deben enfrentar cuando se trata de elecciones y la propagación de desinformación", dice el primer autor William Brady, psicólogo social de la Kellogg School of Management en Northwestern.

"Queríamos realizar una revisión sistemática que intenta ayudar a comprender cómo la psicología humana y los algoritmos interactúan de maneras que pueden tener estas consecuencias", dice Brady. "Una de las cosas que esta revisión trae a la mesa es una perspectiva de aprendizaje social. Como psicólogos sociales, estamos constantemente estudiando cómo podemos aprender de los demás. Este marco es fundamentalmente importante si queremos entender cómo los algoritmos influyen en nuestras interacciones sociales."

Comentarios

Para ver los comentarios de sus colegas o para expresar su opinión debe ingresar con su cuenta de IntraMed.